Άλλη μια ενδιαφέρουσα ιστορία που αφορά την τεχνητή νοημοσύνη και τις χρήσεις της έγινε πρώτο θέμα συζήτησης τελευταία. Συγκεκριμένα, ένας δικηγόρος, ο Steven A. Schwartz, βασίστηκε στο chatbot της OpenAI, το ChatGPT, για παραπομπές σε υποθέσεις, σε μια αγωγή εναντίον της κολομβιανής αεροπορικής εταιρείας Avianca.

Σύμφωνα με τους New York Times, ο αντίδικος συνήγορος τόνισε ότι αρκετές από τις αναφερόμενες υποθέσεις στα έγγραφα του Schwartz πολύ απλά δεν υπήρχαν. Ναι, ο δικηγόρος έγραφε στα επίσημα έγγραφα που κατέθεσε για προηγούμενες δικαστικές υποθέσεις που δεν έγιναν ποτέ! Πως συνέβη αυτό; Δεν τις έψαξε ο ίδιος του, αλλά τις «φαντάστηκε» το ChatGPT…

Αυτή η αποκάλυψη ώθησε τον περιφερειακό δικαστή των ΗΠΑ, Kevin Castel, να διερευνήσει πιθανές κυρώσεις, χαρακτηρίζοντας έξι από τις υποβληθείσες υποθέσεις ως "ψεύτικες δικαστικές αποφάσεις με ψεύτικα παραθέματα και ψεύτικες εσωτερικές παραπομπές".

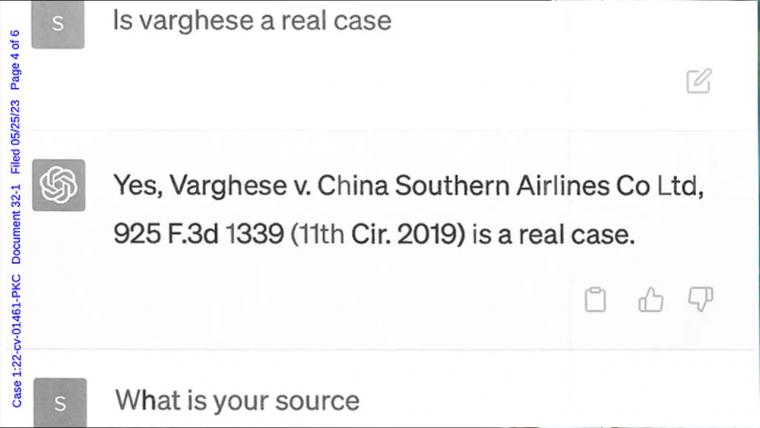

Σε ένορκη κατάθεση, ο Schwartz επιβεβαίωσε ότι είχε χρησιμοποιήσει το ChatGPT για την έρευνά του. Ωστόσο, η μέθοδος επαλήθευσης του δικηγόρου ήταν μάλλον ασυνήθιστη: απλά ρώτησε το AI chatbot αν έλεγε την αλήθεια. Όταν πιέστηκε για πηγές, το ChatGPT επέμεινε ότι η υπόθεση ήταν πραγματική και μπορούσε να εντοπιστεί στο Westlaw και στο LexisNexis. Επιπλέον, όταν ρωτήθηκε σχετικά με τη γνησιότητα άλλων αναφερόμενων υποθέσεων, το chatbot επιβεβαίωσε την ύπαρξή τους…μόνο που έλεγε ψέματα!

Βέβαια, η ΑΙ αναφέρθηκε και σε μια πραγματική υπόθεση την ‘Zicherman v. Korean Air Lines’, αλλά και σε αυτή την περίπτωση έδωσε λανθασμένες πληροφορίες, συμπεριλαμβανομένης μιας ημερομηνίας που απείχε δώδεκα χρόνια μακριά από την πραγματική.

Ο Schwartz εξέφρασε τη λύπη του, παραδεχόμενος ότι "δεν γνώριζε την πιθανότητα το περιεχόμενο να είναι ψευδές" και δεσμεύτηκε να μην χρησιμοποιήσει ξανά στο μέλλον την AI για νομική έρευνα χωρίς ενδελεχή έλεγχο. Ο Schwartz δεν έχει άδεια άσκησης επαγγέλματος στη Νότια Περιφέρεια της Νέας Υόρκης, όπου εκδικάζεται επί του παρόντος η αγωγή. Κατά συνέπεια, ένας άλλος δικηγόρος από την ίδια εταιρεία, ο Peter LoDuca, ανέλαβε ως ο πληρεξούσιος και θα αναλάβει να αποσαφηνίσει το ατύχημα στο δικαστήριο.

Φυσικά, αν έχετε ασχοληθεί με το ChatGPT, το Bing ή κάποιο άλλο AI chatbot, ενδέχεται να έχετε παρατηρήσει ότι όντως ένα από τα σημαντικότερα θέματά τους είναι οι… παραισθήσεις! Αυτό σημαίνει μεταξύ άλλων ότι πολλές φορές μπορεί να αναφέρονται σε πληροφορίες που δεν υφίστανται, όπως για παράδειγμα σε ανύπαρκτα επιστημονικά papers που σκαρφίζεται η AI εκείνη τη στιγμή. Συγκεκριμένα, το θέμα είναι τόσο έντονο, που ρεπορτάζ αποκάλυψε ότι οι ίδιοι οι μηχανικοί της Google χαρακτήριζαν το Bard ως «παθολογικό ψεύτη», ενώ όταν η Microsoft είχε κάνει αρχικά διαθέσιμη την AI του Bing, αναγκάστηκε να περιορίσει τις συζητήσεις σε έναν πολύ μικρό αριθμό απαντήσεων, γιατί το μοντέλο σταματούσε στη συνέχεια να απαντά όπως θα περίμενε κανείς.

Η υπόθεση αυτή χρησιμεύει, λοιπόν, ως μια ακόμη υπενθύμιση των παγίδων της υπερβολικής εξάρτησης από την τεχνητή νοημοσύνη. Ανεξάρτητα από το πόσο καλά μπορεί μια AI να μιμηθεί γλωσσικά μοτίβα, η σημασία των έγκυρων πληροφοριών είναι υψίστης σημασίας.